vit论文解读、volume 论文

在2020年由Google推出的ViT视觉Transformer,即视觉领域中的Transformer模型,引发了深度学习领域的广泛关注其原始论文和基于PyTorch实现的代码均可以公开获取,供研究者

在2020年由Google推出的ViT视觉Transformer,即视觉领域中的Transformer模型,引发了深度学习领域的广泛关注其原始论文和基于PyTorch实现的代码均可以公开获取,供研究者们学习和扩展要使用ViT,首先需要理解其关键参数在调用代码的过程中,以下参数是核心组成部分输入张量表示图像数据,Transformer模型。

而 ViT 通过全局感受野的注意力机制提取特征,从一开始就强调了相比 ConvNet 的局部感受野,全局自注意力模式在数据量巨大时性能更优随着时间的推移,这一观点逐渐被广泛认可,并在众多 SOTA 刷榜论文中得到验证2 从 ViT 到 MLPMixer 和 ConvMixer 随着 Transformer 的发展,MLPMixer 和 Conv。

训练不稳定主要与学习率batch size和优化器的选择有关在大batch size4096情况下,模型训练曲线容易出现剧烈抖动,测试性能在bs=2048时表现最佳,这与MoCo v1中“batch size越大,对比学习效果越好”的观点相悖训练曲线抖动的可能原因在于梯度剧变,作者对ViT的第一层和最后一层梯度的无穷范数。

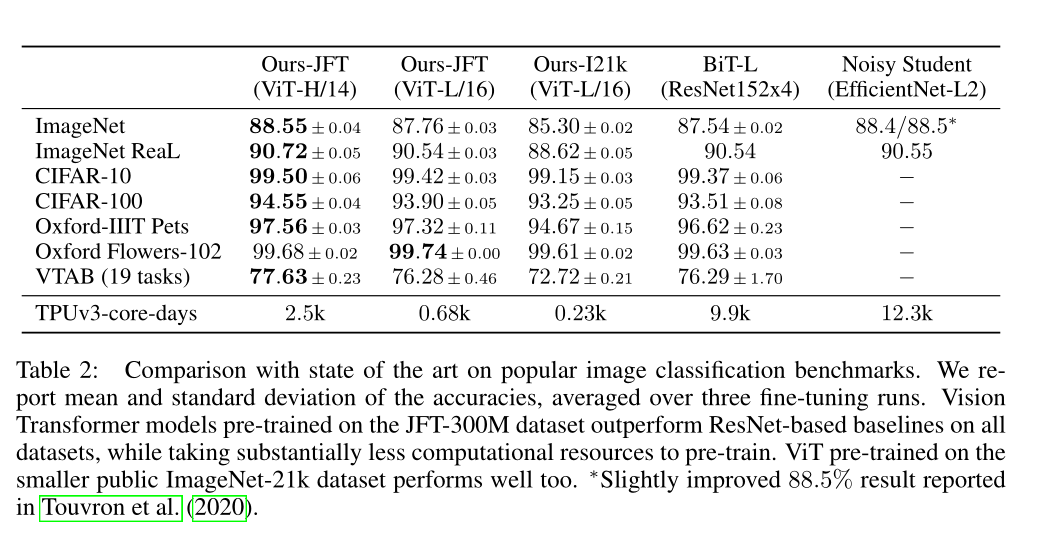

Vision Transformer论文精读,直击核心观点1 Transformer在视觉领域的突破 VIT首次展示了纯Transformer结构在ImageNet 1K图像分类任务上达到8855%的高精度,挑战了CNN的主导地位,推动了多模态领域的发展2 模型结构与比较 作者通过ResNetViTTransformer模型和HybridCNN+Transformer混合的对比。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~