telegraph汉化官网下载

nltk分词、nltk分词原理

1、一NLTK进行分词 用到的函数nltksent_tokenizetext #对文本按照句子进行分割 nltkword_tokenizesent #对句子进行分词 二NLTK进行词性标注 用到的函数nltkpos_tagtokens#tokens是句子分词后的结果,同样是句子级的标注 三NLTK进行命名实体识别NER用到的函数nltkne_chunktags。

2、中文和英文主要的不同之处是中文需要分词因为nltk 的处理粒度一般是词,所以必须要先对文本进行分词然后再用nltk 来处理不需要用nltk 来做分词,直接用分词包就可以了严重推荐结巴分词,非常好用中文分词之后,文本就是一个由每个词组成的长数组word1, word2, word3 wordn之后。

3、分词是动词的三种非限定形式之一,分为两种现在分词和过去分词现在分词一般有四种形式,基本形式为“动词原形+ing”,完成式为having加过去分词,一般被动式为being加过去分词,完成被动式为having been加过去分词,而过去分词只有一种形式,规则动词的过去分词由动词原形加ed构成,不规则动词需要单独记。

4、python做中文分词处理主要有以下几种结巴分词NLTKTHULAC 1fxsjyjieba 结巴的标语是做最好的 Python 中文分词组件,或许从现在来看它没做到最好,但是已经做到了使用的人最多结巴分词网上的学习资料和使用案例比较多,上手相对比较轻松,速度也比较快结巴的优点支持三种分词模式 支持繁体分词。

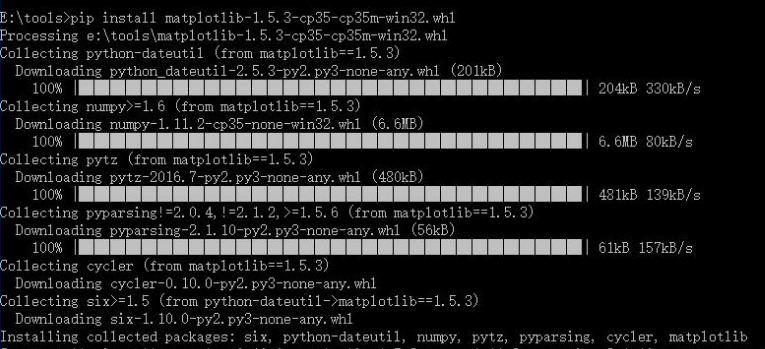

5、Nltk是python下处理语言的主要工具包,可以实现去除停用词词性标注以及分词和分句等安装nltk,写python一般使用的是集成环境EPD,其中有包管理,可以在线进行安装如果不是集成环境,可以通过pip install nltk安装pip install nltk #安装nltk nltkdownload #弹出一个选择框,可以按照自己。

6、中文主要有NLTK,HanLP,Ansj,THULAC,结巴分词,FNLP,哈工大LTP,中科院ICTCLAS分词,GATE,SnowNLP,东北大学NiuTrans,NLPIR英文主要有NLTK,Genism,TextBlob,Stanford NLP,Spacy英文的开源NLP工具主要参见StackoverFlowjava or python for nlpHanLPHanLP是由一系列模型与算法组成的Java工具。

7、1 NLTK NLTK是一款强大的自然语言处理工具包,主要用于文本分析它提供了丰富的文本处理功能,如分词词性标注句法分析等通过NLTK,用户可以轻松进行文本数据的分析和挖掘四文本格式化软件 Markdown编辑器 Markdown编辑器是一种轻量级的文本格式化工具,用于将纯文本转换为具有结构和样式的文档它。

8、接下来,利用自然语言处理技术,将单词列表进行分词和标注分词是将句子拆分成独立的词汇单元,而标注则是为每个词汇添加相应的发音信息这个过程中,可以使用现有的自然语言处理工具包,如NLTKspaCy等,它们提供了丰富的分词和标注功能然后,将分词和标注后的单词列表与发音数据库进行匹配对于每个单词。

9、有几种方法可以将文本转换为数据最流行的方法之一是文本矢量化,即将文本转换为数字表示的过程有几种方法可以实现文本矢量化,如二进制词频词袋BoW词频L1归一化词频L2归一化TFIDF和Word2Vec12另一种方法是命名实体识别NER,这是一种信息提取的子任务,旨在定位文本中。

10、\x0d\x0a\x0d\x0a抓取下来的数据,需要做分词处理,Python在这方面也不逊色,著名的自然语言处理程序包NLTK,还有专门做中文分词的Jieba,都是做分词的利器\x0d\x0a\x0d\x0a数据处理\x0d\x0a\x0d\x0a万事俱备,只欠东风这东风,就是数据处理算法从统计理论,到数据挖掘,机器学习,再到最近几年。

11、步骤二PDF文献的深度挖掘面对PDF文献的海量信息,AI也能大展身手通过遍历文件夹,利用nltk和jieba库进行深度处理,提取文本,统计词频,然后生成一份既全面又精准的PDF词云图,再通过Excel进行详细的数据分析数据预处理,精益求精在生成词云图之前,分词去停用词和转小写等步骤必不可少这些技术手段。

12、1 收集相关数据首先,您需要收集一些与您想要生成的文章相关的数据这可以包括其他文章论坛帖子新闻报道等您可以使用网络爬虫工具来收集这些数据2 数据预处理在生成文章之前,您需要对收集到的数据进行预处理这包括去除无关信息清洗文本分词等操作您可以使用自然语言处理工具如NLTK。

13、1 数据收集收集与孔雀蓝相关的文章新闻博客等文本数据您可以通过网络搜索文献调研或者使用相应的数据集来获取这些数据2 数据预处理对收集到的文本数据进行预处理,包括去除特殊字符标点符号停用词等,以及进行分词处理这一步可以使用Python中的NLP库,如NLTKspaCy或jieba等3。

14、Tokenizer是执行Tokenize操作的工具或函数不同的编程语言和库可能提供不同的Tokenizer实现例如,在Python中,NLTK库和Spacy库都提供了Tokenizer功能这些Tokenizer能够处理多种语言,并提供了丰富的选项和功能,如分词词性标注命名实体识别等总的来说,TokenTokenize和Tokenizer是自然语言处理和文本。

15、在实验室中,我们可以按照以下步骤进行LDA实验首先,我们需要准备一组文本数据集,例如一系列文章新闻或者评论然后,我们可以用Python编程语言中的自然语言处理库如NLTKGensim来实现LDA算法接下来,我们需要对文本进行预处理,包括分词去除停用词词干化等最后,我们可以利用LDA模型对文本。

相关文章

- skype和line之间的差异、skype for business和skype一样吗

- 泰达币跟比特币哪个更安全、泰达币跟比特币哪个更安全一些

- token钱包里的钱咋个转出来、tokenpocket钱包如何提现

- telegreat中文版苹果、telegraph苹果中文版下载官网

- TG官网、TG官网入口

- u币多少钱一个、1个u币值多少人民币

- 纸飞机telegeram注册方法、纸飞机telegeram收不到短信

- telegreat解除双向限制要多久、telegram登录次数多登不上怎么搞

- coinbaseapp排名、coin coinbase global

- travian官网、ptrade量化交易软件官网

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~